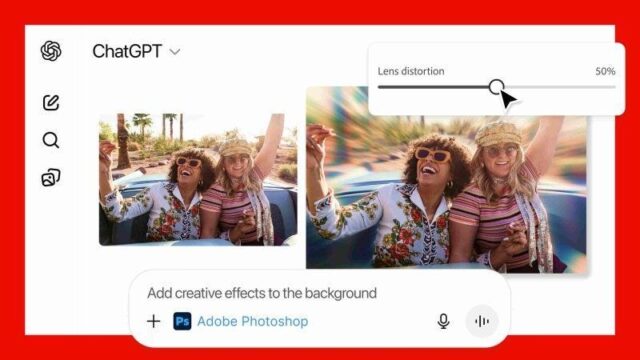

アメリカのビッグテック各社による人工知能(AI)インフラの確保競争が、かつてないスピードで加熱している。GPT-3やGemini、Claudeといったモデル性能を軸に展開された「第1ラウンド」のAI競争が一区切りを迎え、今や勝敗を分けるのはインフラの規模と資本の動員力となった。演算能力や電力供給、クラウド基盤までを含めた「第2ラウンド」が本格化し、AI戦争の様相は大きく変わりつつある。

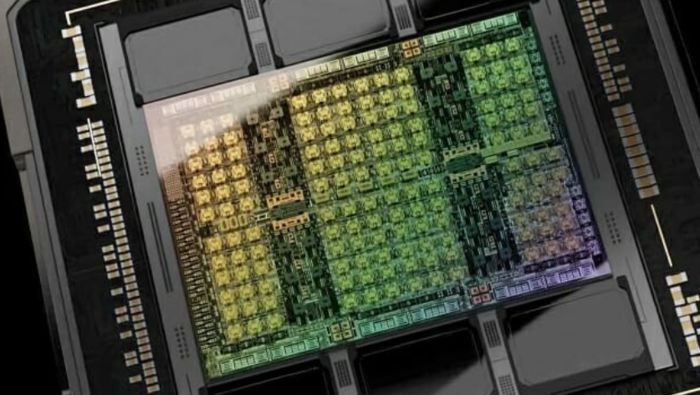

米IT専門メディア「The Information」によると、OpenAIは現在、400億ドル(約5兆9,090億円)規模の資金調達を急ピッチで進めている。Founders FundとDragoneerがそれぞれ10億ドル(約1,476 億円)超の投資を約束しており、4月にはソフトバンクが100億ドル(約 1兆4,762億円)を出資。これによりOpenAIは、今年だけで135億ドル(約 1兆9,930億円)を確保したことになる。OpenAIは年末までにグラフィックス処理装置(GPU)を100万台確保し、AIモデルの学習およびリアルタイムサービスに投入する計画だ。単なる資金調達ではなく、将来のAI市場で主導権を握るための先行投資と位置づけられている。

GPU確保で最も先行しているのは、イーロン・マスク率いるxAIだ。現在23万台のGPUを稼働させているデータセンター「Colossus 1」に続き、55万台を投入する「Colossus 2」の稼働が間近に迫っている。マスク氏は自身が運営するSNS「X」で「今後5年以内に5,000万台のH100級GPUを確保する」と明言しており、そのための120億ドル(約 1兆7,716億円)規模の資金調達も進行中だ。「こうしたインフラがなければ、ロボタクシーやヒューマノイドのような高度なAIシステムを学習させることはできない」と語っており、GPUは今やロボットや自動運転車の「脳」を作る前提条件となっている。

グーグルの親会社アルファベットも、23日の2024年第2四半期決算発表で、AIインフラ投資額を850億ドル(約 12兆5,494億円)に引き上げたと明らかにした。計画を100億ドル(約 1兆4,762億円)以上上回る規模である。スンダー・ピチャイCEOは「AIインフラへの投資は、クラウド顧客の需要増に対応するための必須戦略だ」と述べ、全社的なAIシフトを予告した。グーグルはすでに米東部のPJM送電網地域で大規模なデータセンター拡張を進めており、電力リソースまで含めた「AIエコシステム拡張」を狙っている。

ビッグテックがGPUに天文学的な資金を注ぎ込む理由は、「スケーリング法則」にある。大量のGPUを投入すれば、モデルの性能が予測可能な形で向上するというこの法則は、依然としてAI開発の基本的アプローチである。最近では、電力消費や収益性の低下、性能向上の限界などを理由にスケーリングの有効性に疑問を呈する声もあるが、より優れたアルゴリズムやアーキテクチャといった代替策はまだ十分に成熟していない。特にChatGPTやCopilotのようにリアルタイム応答が求められる生成AIサービスでは、学習だけでなく運用にも多くのGPUが必要となる。AIが「常時待機状態」で稼働する時代、運用用GPUの重要性も一段と高まっている。

この争いは、技術的競争を超えた「防衛戦」の様相も帯びている。エヌビディアの最新GPU供給が限定的である中、先に確保した企業は競合より

も早く、低コストで高性能モデルを市場に出すことができるからだ。そのため、各社は自社のAIエコシステム強化を目的に、GPUへの投資を加速させている。マイクロソフトはOpenAIの技術とAzureクラウドを連携させて開発者の囲い込みを図っており、メタやグーグルも同様にプラットフォームの影響力拡大に注力している。GPUは今や単なる演算資源ではなく、AI覇権を握るための“戦略兵器”と化している。

あるシリコンバレーのビッグテック企業開発者はこう語る。「いまGPUを確保できなければ、AI覇権競争、さらには汎用人工知能(AGI)競争でも後れを取ることになる、という危機感がビッグテックを動かしている」

コメント0